N8n Pinecone Vector Store Setup: अपने AI Agent को दें ‘Unlimited Memory’! जानिए RAG वर्कफ़्लो बनाने का सही तरीका।

Dosto, क्या आप एक ऐसा AI Chatbot बनाना चाहते हैं जिसे आपकी कंपनी की हर फाइल, हर पॉलिसी और हर डेटा के बारे में पता हो? इसके लिए आपको जरूरत पड़ती है RAG (Retrieval-Augmented Generation) की, और RAG का सबसे जरूरी हिस्सा है— Vector Store.

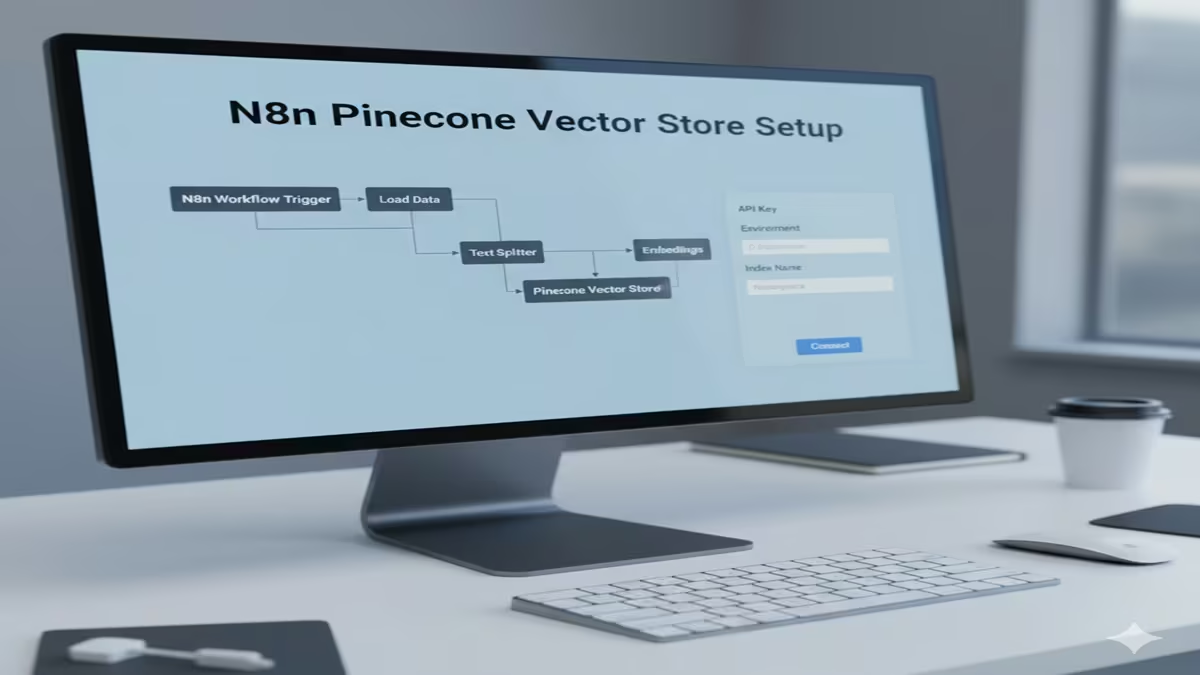

आज के इस ट्यूटोरियल में हम सीखेंगे कि n8n में Pinecone Vector Store कैसे सेटअप करें। अगर आप अपने AI Agent को ‘Super Memory’ देना चाहते हैं, तो यह गाइड आपके लिए ‘Holy Grail’ साबित होगी।

1. Pinecone क्या है और n8n में इसकी क्या जरूरत है?

Pinecone एक ‘Vector Database’ है। साधारण डेटाबेस (जैसे SQL) टेक्स्ट स्टोर करते हैं, लेकिन Pinecone ‘Embeddings’ (नंबर्स की लिस्ट) स्टोर करता है।

जब आप n8n में कोई AI Agent बनाते हैं, तो उसे पुरानी बातें याद दिलाने या आपके प्राइवेट डेटा से जवाब देने के लिए Pinecone जैसे Vector Store की जरूरत पड़ती है। 2026 में, Pinecone ने अपना नया ‘Pinecone Assistant Node’ भी लॉन्च किया है जो n8n के साथ और भी स्मूथ चलता है।

2. Step-by-Step Setup: n8n को Pinecone से कैसे जोड़ें?

Step 1: Pinecone पर इंडेक्स (Index) बनाएँ

- Pinecone.io पर साइन-अप करें।

- डैशबोर्ड में ‘Create Index’ पर क्लिक करें।

- Dimensions: अगर आप OpenAI का

text-embedding-3-smallमॉडल इस्तेमाल कर रहे हैं, तो डाइमेंशन 1536 रखें। - Metric: ‘Cosine’ चुनें (यह टेक्स्ट सर्च के लिए बेस्ट है)।

Step 2: API Key जनरेट करें

- Pinecone डैशबोर्ड में ‘API Keys’ सेक्शन में जाएँ।

- एक नई की (Key) बनाएँ और उसे कॉपी कर लें।

Step 3: n8n में क्रेडेंशियल्स (Credentials) सेट करें

- अपने n8n इंस्टेंस में जाएँ।

- ‘Credentials’ में जाकर ‘Pinecone API’ चुनें।

- अपनी API Key पेस्ट करें और ‘Environment’ (जैसे

us-east-1) चेक करें।

3. N8n Workflow में Pinecone Node का इस्तेमाल कैसे करें?

Pinecone को n8n में दो तरह से इस्तेमाल किया जा सकता है:

A. डेटा इंसर्ट करने के लिए (Upsert Mode):

- सबसे पहले ‘Default Data Loader’ नोड जोड़ें (PDF या Text फाइल लोड करने के लिए)।

- इसके बाद ‘Recursive Character Text Splitter’ जोड़ें (ताकि डेटा छोटे टुकड़ों में बँट जाए)।

- फिर ‘Embeddings OpenAI’ नोड जोड़ें।

- आखिरी में ‘Pinecone Vector Store’ नोड जोड़ें और ‘Operation’ में ‘Insert Documents’ चुनें।

B. डेटा रिट्रीव करने के लिए (Retrieve-as-Tool Mode):

- अपने ‘AI Agent’ नोड के टूल कनेक्टर से ‘Pinecone Vector Store’ को जोड़ें।

- ‘Operation’ में ‘Retrieve Documents (As Tool for AI Agent)’ चुनें।

- अब आपका AI एजेंट सवाल पूछने पर पहले Pinecone में सर्च करेगा और फिर जवाब देगा।

4. Pinecone Assistant Node (The New 2026 Feature)

अगर आप अलग-अलग नोड्स (Embeddings, Splitter, Vector Store) को मैन्युअल रूप से कनेक्ट नहीं करना चाहते, तो n8n का नया Pinecone Assistant Node इस्तेमाल करें। यह ‘All-in-one’ सॉल्यूशन है जो खुद ही फाइल अपलोड, चंकिंग और एम्बेडिंग को हैंडल कर लेता है।

5. Common Mistakes: इनसे बचें!

- Dimension Mismatch: अगर आपके एम्बेडिंग मॉडल के डाइमेंशन्स और Pinecone इंडेक्स के डाइमेंशन्स मैच नहीं हुए (उदा. 1536 vs 768), तो वर्कफ़्लो फेल हो जाएगा।

- Missing Metadata: डेटा इंसर्ट करते समय ‘Metadata’ जरूर जोड़ें ताकि AI को पता रहे कि जानकारी किस सोर्स से आ रही है।

Conclusion: क्यों है यह बेस्ट?

N8n Pinecone Vector Store Setup न सिर्फ आपके AI को इंटेलिजेंट बनाता है, बल्कि यह आपके बिजनेस डेटा को सुरक्षित और एक्सेसिबल भी रखता है। चाहे आप कस्टमर सपोर्ट बॉट बना रहे हों या पर्सनल रिसर्च असिस्टेंट, Pinecone और n8n की जोड़ी बेमिसाल है।

Quick Configuration Table

| Parameter | Recommended Value |

| Embedding Model | OpenAI text-embedding-3-small |

| Dimensions | 1536 |

| Metric | Cosine Similarity |

| n8n Operation | Insert / Retrieve as Tool |

| Namespace | (Optional) For data filtering |

n8n Pinecone Vector Store Setup: अपने AI Agent को दें ‘Unlimited Memory’! जानिए RAG वर्कफ़्लो बनाने का सही तरीका

🌟 परिचय: AI एजेंट्स की याद्दाश्त की समस्या

n8n Pinecone Vector Store Setup: आर्टिफिशियल इंटेलिजेंस (AI) की दुनिया में सबसे बड़ी चुनौतियों में से एक है“मेमोरी”की समस्या। चाहे आप ChatGPT का उपयोग करें या किसी अन्य Large Language Model (LLM) का, उनके पास आपके निजी डेटा, कंपनी की पॉलिसी या पुराने दस्तावेज़ों की जानकारी नहीं होती है। वे केवल उसी डेटा तक सीमित होते हैं, जिस पर उन्हें प्रशिक्षित (Train) किया गया है।

यहीं पर Retrieval-Augmented Generation (RAG) तकनीक काम आती है। RAG एक ऐसा आर्किटेक्चर है, जो AI मॉडल को बाहरी स्रोतों (जैसे कि डेटाबेस, PDF फाइलें, या वेबसाइट) से जानकारी निकालने और उसके आधार पर सटीक जवाब देने की क्षमता प्रदान करता है । इसे AI को “असीमित मेमोरी” (Unlimited Memory) देने जैसा समझें।

इस लेख में, हम सीखेंगे कि कैसे आप n8n (एक लो-कोड ऑटोमेशन टूल) और Pinecone (एक वेक्टर डेटाबेस) का उपयोग करके एक शक्तिशाली RAG वर्कफ़्लो बना सकते हैं। यह आपके AI Agent को आपके अपने डेटा के साथ इंटरैक्ट करने और सटीक, संदर्भ-आधारित उत्तर प्रदान करने में सक्षम बनाएगा।

🤔 RAG क्या है और यह क्यों जरूरी है?

n8n Pinecone Vector Store Setup: RAG का पूरा नामRetrieval-Augmented Generationहै। यह एक ऐसी प्रक्रिया है जो दो मुख्य चरणों में काम करती है:

- Retrieval (पुनर्प्राप्ति):जब उपयोगकर्ता एक प्रश्न पूछता है, तो सिस्टम पहले आपके अपने डेटा स्रोत (जैसे Pinecone) में खोज करता है और प्रश्न से संबंधित सबसे प्रासंगिक जानकारी (या “संदर्भ”) ढूंढता है। यह जानकारी आमतौर पर टेक्स्ट के छोटे-छोटे टुकड़ों (चंक्स) के रूप में होती है।

- Generation (निर्माण):फिर, इस प्राप्त जानकारी (संदर्भ) को मूल प्रश्न के साथ LLM (जैसे GPT-4 या Gemini) को भेज दिया जाता है। LLM अब केवल अपने प्रशिक्षण डेटा पर निर्भर नहीं रहता, बल्कि आपके द्वारा दिए गए विशिष्ट संदर्भ का उपयोग करके एक सटीक और अद्यतन उत्तर तैयार करता है।

RAG के फायदे:

- सटीकता:AI अब केवल सामान्य ज्ञान के आधार पर नहीं, बल्कि आपके दस्तावेज़ों के आधार पर जवाब देता है, जिससे गलत सूचना (Hallucination) की संभावना कम हो जाती है।

- अद्यतन जानकारी:आप अपने ज्ञानकोष (Knowledge Base) को अपडेट कर सकते हैं, और AI तुरंत नई जानकारी का उपयोग करना शुरू कर देगा, बिना उसे दोबारा प्रशिक्षित (Retrain) किए।

- डेटा प्राइवेसी:आपका संवेदनशील डेटा आपके अपने वेक्टर डेटाबेस में रहता है और उसे सार्वजनिक LLM के साथ साझा नहीं करना पड़ता।

🛠️ आवश्यक उपकरण (Tech Stack)

n8n Pinecone Vector Store Setup: इस प्रोजेक्ट को बनाने के लिए हमें तीन मुख्य चीज़ों की आवश्यकता होगी:

- n8n (वर्कफ़्लो ऑटोमेशन प्लेटफॉर्म):n8n एक शक्तिशाली लो-कोड टूल है जो विभिन्न ऐप्स और सर्विसेज को आपस में जोड़ता है। यह हमारे RAG पाइपलाइन का दिमाग होगा, जो सभी कार्यों को ऑर्केस्ट्रेट करेगा।

- Pinecone (वेक्टर डेटाबेस):Pinecone एक पूर्ण रूप से प्रबंधित (Fully Managed) वेक्टर डेटाबेस है। यह हमारे डेटा के “एम्बेडिंग” (वेक्टर रूप) को स्टोर करेगा और सिमेंटिक सर्च (अर्थ के आधार पर खोज) को संभव बनाएगा।

- OpenAI / Gemini (LLM और एम्बेडिंग मॉडल):

🏗️ RAG वर्कफ़्लो को समझना: दो मुख्य चरण

n8n Pinecone Vector Store Setup: एक संपूर्ण RAG सिस्टम बनाने के लिए, हमें दो अलग-अलग वर्कफ़्लो बनाने होंगे: एक डेटा इन्जेशन (Data Loading/Ingestion) के लिए और दूसरा डेटा रिट्रीवल (Data Retrieval) यानि प्रश्नोत्तर (Q&A) के लिए।

चरण 1: डेटा इन्जेशन वर्कफ़्लो (अपने डेटा को Pinecone में फीड करना)

n8n Pinecone Vector Store Setup: यह पहला चरण है, जिसमें हम अपने डॉक्यूमेंट्स (जैसे PDF, Word फाइल, वेबसाइट कंटेंट) को लेकर उन्हें Pinecone में स्टोर करते हैं। इसे हम एक बार सेट कर देते हैं, और यह स्वचालित रूप से नए डेटा को इंडेक्स करता रहता है।

वर्कफ़्लो के स्टेप्स:

- n8n Pinecone Vector Store Setup: ट्रिगर (Trigger):“Google Drive Trigger” का उपयोग करें। यह नोड आपके Google Drive के किसी खास फोल्डर पर नज़र रखेगा। जैसे ही आप उस फोल्डर में कोई नई फाइल (जैसे “HR-Policy.pdf”) अपलोड करेंगे, वर्कफ़्लो शुरू हो जाएगा।

- n8n Pinecone Vector Store Setup: डाउनलोड:“Google Drive” नोड का उपयोग करके उस नई फाइल को डाउनलोड करें।

- n8n Pinecone Vector Store Setup: टेक्स्ट एक्सट्रैक्शन (Loader):“Default Data Loader” या “Binary to JSON” नोड का इस्तेमाल करके PDF या Docx फाइल से टेक्स्ट निकालें।

- n8n Pinecone Vector Store Setup: टेक्स्ट स्प्लिटिंग (Chunking):LLMs और एम्बेडिंग मॉडल की एक सीमित क्षमता (Token Limit) होती है। इसलिए बड़े डॉक्यूमेंट को छोटे-छोटे टुकड़ों (Chunks) में बांटना जरूरी है। “Recursive Character Text Splitter” नोड का उपयोग करें। इसे चंक साइज (जैसे 500 या 1000 टोकन) और चंक ओवरलैप (जैसे 50 टोकन) के साथ कॉन्फ़िगर करें ताकि संदर्भ (Context) न छूटे।

- n8n Pinecone Vector Store Setup: एम्बेडिंग जनरेशन:अब, “OpenAI Embeddings” या “Gemini Embeddings” नोड का उपयोग करके हर टेक्स्ट चंक को एक वेक्टर (संख्यात्मक रूप) में बदलें।

- Pinecone में डालें (Insert):अंत में, “Pinecone Vector Store” नोड लें। इसके Operation को “Insert” पर सेट करें। अपना Pinecone इंडेक्स (जो आपने Pinecone डैशबोर्ड पर बनाया है) चुनें और नेमस्पेस (Namespace) डालें (जैसे “company_policies”)। यह नोड एम्बेडिंग और मूल टेक्स्ट को Pinecone में स्टोर कर देगा।

परिणाम: अब आपकी कंपनी की सभी नीतियां Pinecone में सर्च करने योग्य (Searchable) हो गई हैं।

चरण 2: डेटा रिट्रीवल वर्कफ़्लो (AI चैटबॉट बनाना)

n8n Pinecone Vector Store Setup: एक बार जब आपका डेटा Pinecone में आ जाता है, तो दूसरा वर्कफ़्लो उपयोगकर्ताओं के सवालों का जवाब देने के लिए तैयार है।

वर्कफ़्लो के स्टेप्स:

- n8n Pinecone Vector Store Setup: चैट ट्रिगर (Chat Trigger):“When Chat Message Received” नोड का उपयोग करें। यह एक वेबहुक की तरह काम करता है और आपके चैटबॉट के लिए एक साधारण चैट इंटरफेस प्रदान करता है।

- n8n Pinecone Vector Store Setup: AI Agent:यह आपके पूरे सिस्टम का कोर है। “AI Agent” नोड को कैनवास पर जोड़ें। इसे एक सिस्टम मैसेज दें, जैसे: “आप एक सहायक हैं जो कंपनी की नीतियों के बारे में सवालों के जवाब केवल दिए गए संदर्भ के आधार पर देते हैं।”

- n8n Pinecone Vector Store Setup: मेमोरी (Memory):“Simple Memory” नोड को AI Agent से जोड़ें। यह बातचीत के इतिहास (Chat History) को याद रखेगा, जिससे मल्टी-टर्न बातचीत (जैसे “उसके बारे में और बताओ”) संभव हो सकेगी।

- n8n Pinecone Vector Store Setup: टूल्स (Tools):AI Agent को टूल्स की जरूरत होती है ताकि वह बाहरी दुनिया से बातचीत कर सके। यहां हम “Vector Store Question and Answer Tool” का उपयोग करेंगे। इस टूल को एक नाम और विवरण दें, जैसे: “कंपनी_नीति_उपकरण: कंपनी की HR और IT नीतियों के बारे में सवालों के जवाब के लिए इस टूल का उपयोग करें।” यह विवरण बहुत महत्वपूर्ण है, क्योंकि AI Agent यही पढ़कर तय करता है कि कब इस टूल को कॉल करना है।

- n8n Pinecone Vector Store Setup: Pinecone रिट्रीवर:“Vector Store QnA Tool” के अंदर, एक “Pinecone Vector Store” नोड जोड़ें। इसका Operation “Retrieve Documents” पर सेट करें। इसे उसी Pinecone इंडेक्स और नेमस्पेस से कनेक्ट करें, जिसमें आपने डेटा डाला था। इस नोड के ऑप्शन में आप “Top K” सेट कर सकते हैं कि कितने सबसे संबंधित दस्तावेज़ (चंक) लौटाए जाने चाहिए (जैसे 4 या 5)।

- n8n Pinecone Vector Store Setup: LLM:AI Agent को एक शक्तिशाली LLM से कनेक्ट करें, जैसे “OpenAI Chat Model” (GPT-4) या “Gemini Chat Model”। यह मॉडल Pinecone से प्राप्त संदर्भ और उपयोगकर्ता के प्रश्न को लेकर अंतिम उत्तर तैयार करेगा।

अंतिम परिणाम:जब कोई उपयोगकर्ता पूछता है, “मुझे WFH पॉलिसी के बारे में बताएं?

💡 उन्नत टिप्स और ट्रिक्स (Advanced Tips)

n8n Pinecone Vector Store Setup: एक बुनियादी RAG सेटअप तो काम कर जाएगा, लेकिन इसे और बेहतर बनाने के लिए आप निम्नलिखित तकनीकों का उपयोग कर सकते हैं:

- मेटाडेटा फ़िल्टरिंग (Metadata Filtering):Pinecone में डेटा डालते समय, उसके साथ मेटाडेटा (जैसे

विभाग: HR, यातिथि: 2024) भी स्टोर करें। जब उपयोगकर्ता “HR पॉलिसी 2024” के बारे में पूछे, तो आप रिट्रीवल नोड में एक मेटाडेटा फ़िल्टर लगा सकते हैं, जिससे और भी सटीक परिणाम मिलेंगे। - हाइब्रिड सर्च (Hybrid Search):केवल वेक्टर सर्च पर निर्भर न रहें। कभी-कभी कीवर्ड सर्च (जैसे BM25) भी जरूरी होता है। आप दोनों तरह की सर्च के नतीजों को जोड़कर (Fusion) बेहतर रिजल्ट पा सकते हैं।

- अलग-अलग डेटा सोर्स:सिर्फ Google Drive ही नहीं, बल्कि आप n8n की मदद सेWordPress,Notion,Databases, यावेबसाइटोंसे भी डेटा क्रॉल करके Pinecone में डाल सकते हैं। यह आपके AI Agent को और भी शक्तिशाली बनाता है।

- लोकल मॉडल (Local Models):यदि डेटा गोपनीयता आपके लिए सर्वोच्च प्राथमिकता है, तो आप OpenAI के बजायOllama(जैसे Llama 3) औरQdrant(Pinecone के विकल्प के रूप में) का उपयोग करके पूरा सिस्टम अपने लोकल सर्वर पर चला सकते हैं।

🎯 निष्कर्ष: अपने AI की शक्ति को अनलॉक करें

n8n Pinecone Vector Store Setup: n8n और Pinecone का संयोजन आपको कम कोड में अत्यधिक शक्तिशाली और स्केलेबल RAG एप्लिकेशन बनाने की क्षमता देता है। चाहे आपको एक कंपनी पॉलिसी चैटबॉट बनाना हो, एक वेबसाइट के लिए स्मार� सर्च, या एक निजी डेटा विश्लेषक, यह तकनीक आपको “असीमित मेमोरी” वाला AI Agent बनाने में सक्षम बनाती है।

तो देर किस बात की? आज ही एक नि:शुल्क Pinecone अकाउंट बनाएं, n8n सेट करें, और अपने डेटा को बोलना सिखाएं!

❓ अक्सर पूछे जाने वाले प्रश्न (5 FAQ)

प्रश्न 1: क्या RAG सेटअप करने के लिए मुझे प्रोग्रामिंग आनी चाहिए?

उत्तर:n8n Pinecone Vector Store Setup: n8n एक लो-कोड प्लेटफॉर्म है, जिसका मतलब है कि आपको हर चीज के लिए कोड लिखने की जरूरत नहीं है। ड्रैग-एंड-ड्रॉप इंटरफेस और पहले से बने टेम्प्लेट्सकी मदद से आप बिना गहरी प्रोग्रामिंग जानकारी के भी एक बेसिक RAG सिस्टम बना सकते हैं। हां, थोड़ी बहुत टेक्निकल समझ (जैसे API क्या है) जरूर काम आएगी।

प्रश्न 2: क्या मैं अपने डेटा के लिए किसी भी फाइल फॉर्मेट का उपयोग कर सकता हूं?

उत्तर:n8n Pinecone Vector Store Setup: हाँ, n8n विभिन्न प्रकार के डेटा सोर्स और फाइल फॉर्मेट को सपोर्ट करता है। सबसे आम फॉर्मेट PDF, DOCX (Word), TXT और सादे टेक्स्ट हैं। आप “Default Data Loader” नोड का उपयोग करके इन फाइलों से आसानी से टेक्स्ट निकाल सकते हैं। इसके अलावा, वर्डप्रेस जैसी वेबसाइटों या Google Drive जैसी क्लाउड स्टोरेज से भी डेटा ले सकते हैं.

प्रश्न 3: क्या मैं बिना OpenAI के, कोई मुफ्त या लोकल मॉडल इस्तेमाल कर सकता हूं?

उत्तर:n8n Pinecone Vector Store Setup: बिल्कुल! यह RAG सेटअप का एक बड़ा फायदा है। आप OpenAI के बजाय Google केGeminiमॉडल का उपयोग कर सकते हैं, जिसकी शुरुआत में एक मुफ्त सीमा (Free Tier) होती है। इससे भी आगे, आपOllamaका उपयोग करके अपने ही कंप्यूटर परLlama 3, Mistralजैसे ओपन-सोर्स मॉडल चला सकते हैं और उन्हें n8n से जोड़ सकते हैं। इस तरह आपका सारा डेटा और प्रोसेसिंग पूरी तरह से निजी (Private) रहती है।

प्रश्न 4: अगर मेरा डेटा Pinecone में पुराना हो जाए या मैं उसे हटाना चाहूं तो क्या होगा?

उत्तर:n8n Pinecone Vector Store Setup: Pinecone और n8n का आधिकारिक नोडडेटा प्रबंधन के लिए कई ऑपरेशन प्रदान करता है। आप किसी विशेष फाइल को उसकेExternal File IDसे अपडेट (Update File) या डिलीट (Delete File) कर सकते हैं। डेटा इन्जेशन वर्कफ़्लो को इस तरह डिज़ाइन किया जा सकता है कि जब भी Google Drive में कोई फाइल अपडेट हो, तो वह Pinecone में भी अपडेट हो जाए. यह सुनिश्चित करता है कि आपका AI Agent हमेशा ताज़ा जानकारी के साथ काम करे।

प्रश्न 5: Pinecone के अलावा और कौन से विकल्प हैं जिनका उपयोग मैं n8n के साथ कर सकता हूं?

उत्तर:n8n Pinecone Vector Store Setup: Pinecone एक बेहतरीन प्रबंधित सेवा (Managed Service) है, लेकिन n8n आपको कई विकल्पों की आज़ादी देता है। कुछ लोकप्रिय विकल्प हैं:

Qdrant:यह एक ओपन-सोर्स वेक्टर डेटाबेस है जिसे आप अपने सर्वर पर होस्ट कर सकते हैं (Self-hosted), जिससे पूरा नियंत्रण मिलता है।

Supabase (pgvector):यह एक ओपन-सोर्स Firebase विकल्प है। इसमें PostgreSQL डेटाबेस के साथpgvectorएक्सटेंशन आता है, जो वेक्टर स्टोर की सुविधा देता है।

FAISS (Facebook AI Similarity Search):यह एक लोकल लाइब्रेरी है जो आपके अपने कंप्यूटर पर ही वेक्टर सर्च कर सकती है।